책(The Logical Optimizer) 내용중 Part 2 부분의 PPT 파일이 완성되어 올립니다.

Tstory는 10MB보다 큰 파일은 올릴 수 없게 되어있군요. 파일의 사이즈가 커서 분할 압축하여 올립니다.

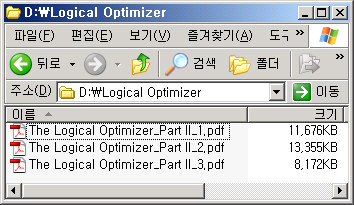

압축을 푸시면 아래그림처럼 3개의 파일이 됩니다. 각각 10MB 정도 되는군요.

첫 번째 파일(The Logical Optimizer_Part II_1)은 Basic 부분(2.A ~2.16장)까지 입니다.

두 번째 파일(The Logical Optimizer_Part II_2)은 Subquery부분(2.17~2.29장)까지 입니다.

세 번째 파일(The Logical Optimizer_Part II_2)은 Data Warehouse부분(2.30~Part2 마무리)까지 입니다.

PPT 파일로 다시 한번 정리하시기 바랍니다.

압축 프로그램 7zip

감사합니다.

'The Logical Optimizer' 카테고리의 다른 글

| The Logical Optimizer-Part 4 PPT (10) | 2010.10.04 |

|---|---|

| The Logical Optimizer-Part 3 PPT (5) | 2010.09.15 |

| Null Aware Hash Anti Join에 관한 오해 (0) | 2010.08.06 |

| NULL AWARE ANTI JOIN은 SQL을 어떻게 변경시키나? (2) | 2010.08.02 |

| The Logical Optimizer Part 1 - PPT (17) | 2010.07.26 |

invalid-file

invalid-file