지난시간의 DEUI라는 기능에 이어서 이번시간에는 그 사촌격인 DE에 대해서 논의해보자.

DE (Distinct Elimination)란 무엇인가

DE는 Unique한 집합일 경우 불필요한 Distinct를 제거하는 기능이다. 이렇게 함으로써 Sort와 중복제거 등의 부하가 많은 작업을 수행하지 않을 수 있다. 이 기능은 Oracle 11g에서 추가되었다. 이제 DE가 어떻게 수행되는지 알아보자.

SELECT distinct d.department_id, l.location_id

FROM department d, location l

WHERE d.location_id = l.location_id ;

----------------------------------------+-----------------------------------+

| Id | Operation | Name | Rows | Bytes | Cost | Time |

----------------------------------------+-----------------------------------+

| 0 | SELECT STATEMENT | | | | 3 | |

| 1 | NESTED LOOPS | | 27 | 270 | 3 | 00:00:01 |

| 2 | TABLE ACCESS FULL | DEPARTMENT| 27 | 189 | 3 | 00:00:01 |

| 3 | INDEX UNIQUE SCAN | LOC_ID_PK | 1 | 3 | 0 | |

----------------------------------------+-----------------------------------+

Predicate Information:

----------------------

3 - access("D"."LOCATION_ID"="L"."LOCATION_ID")

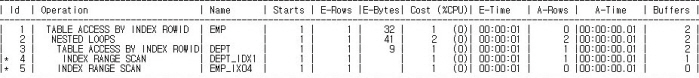

실행계획에서 Distinct에 해당하는 Operation인 Sort Unique 혹은 Hash Unique가 사라졌다. 이유는 Transformer가 위의 SQL을 분석해서 Distinct가 없어도 Unique 함을 알았기 때문이다. Select 절에 있는 d.department_id와 l.location_id는 From 절에 있는 두 테이블의 PK 이다. 따라서 Distinct는 당연히 필요 없음으로 Logical Optimizer가 삭제한 것이다.

아래는 DE와 관련된 10053 Event의 Trace 내용이다.

OBYE: Considering Order-by Elimination from view SEL$1 (#0)

***************************

Order-by elimination (OBYE)

***************************

OBYE: OBYE bypassed: no order by to eliminate.

Eliminated SELECT DISTINCT from query block SEL$1 (#0)

…이후생략

10053 Trace 상에서는 DE가 OBYE 자리에서 발생하였다. 이것은 OBYE 수행여부를 체크할 때 DE의 수행여부를 같이 체크하므로 DE가 OBYE 자리에서 발생되는 것 같다.

함정에 주의할 것

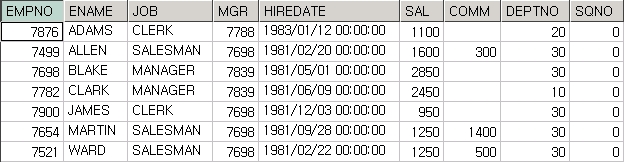

Unique 하다고 해서 항상 DE가 발생될까? 그렇지 않다. 아래의 SQL을 보자.

SELECT distinct d.department_id, d.location_id

FROM department d, location l

WHERE d.location_id = l.location_id ;

위의 SQL은 location_id를 department 테이블의 컬럼으로 대체하였다는 점을 제외하면 최초의 SQL과 완전히 같다.

-----------------------------------------+-----------------------------------+

| Id | Operation | Name | Rows | Bytes | Cost | Time |

-----------------------------------------+-----------------------------------+

| 0 | SELECT STATEMENT | | | | 4 | |

| 1 | HASH UNIQUE | | 27 | 270 | 4 | 00:00:01 |

| 2 | NESTED LOOPS | | 27 | 270 | 3 | 00:00:01 |

| 3 | TABLE ACCESS FULL | DEPARTMENT| 27 | 189 | 3 | 00:00:01 |

| 4 | INDEX UNIQUE SCAN | LOC_ID_PK | 1 | 3 | 0 | |

-----------------------------------------+-----------------------------------+

Predicate Information:

----------------------

4 - access("D"."LOCATION_ID"="L"."LOCATION_ID")

컬럼 하나만이 바뀌었을 뿐인데 실행계획에 Hash Unique가 생긴 것이다. 여기서 알 수 있는 것은 From 절에 나열된 모든 테이블의 PK 컬럼 혹은 Unique 컬럼이 Select 절에 나와야 Distinct가 제거된다는 사실이다. 이것은 아직 DE 기능이 완성되지 않은 것을 의미한다. 논리적으로는 Select 절에 d.location_id를 사용하거나 l.location_id를 사용해도 같기 때문에 DE가 발생 해야 하지만 아직 이런 기능이 없다는 것이 아쉽다.

DE 기능을 Control 하는 파라미터는 _optimizer_distinct_elimination이며 Default로 True 이다. 하지만 이 파라미터로는 DEUI 기능을 Control 할수 없다. 한가지 주의사항은 DE가 버전 10gR2(10.2.0.4)에서도 수행된다는 점이다. 다만 _optimizer_distinct_elimination 파라미터가 없다는 것이 11g와 다른 점이다.

결론

만약 이런 일이 대용량 테이블에서 발생한다면 결과는 심각한 성능저하로 나타날 수 있으므로 조인된 컬럼을 사용할 것인지 아니면 참조되는 컬럼을 사용할 것인지 아주 신중히 결정해야 한다.

성능저하가 예상되는 부분

예를들면 서브쿼리가 Unnesting되어 Distinct가 자동으로 추가된 인라인 뷰에 CVM이 발생하면 인라인뷰가 해체되므로 전체집합에 대해서 Sort Unique 혹은 Hash Unique가 발생된다. 전체집합이 대용량이라면 성능은 심각하게 저하될 것이다. 이 사실은 어떤 컬럼을 Select 절에서 사용할 것인지 아주 신중히 결정해야 하며 Merge 힌트를 얼마나 조심스럽게 사용해야 하는지를 잘 나타내 주고 있다.

PS

이렇게 나가다간 아마 책을 출판할 필요가 없을듯 하다.^^ 하지만 책보다는 블로그가 우선이다.

'Oracle > Optimizer' 카테고리의 다른 글

| 메트릭스나 터미네이터는 먼 미래의 이야기 인가? (2) | 2010.04.28 |

|---|---|

| 해결사 되기 (15) | 2010.02.04 |

| Index Unque Scan은 SQL을 변경시킨다 (6) | 2010.01.20 |

| 내가 사용한 Hint 가 무시되는 이유 (10) | 2010.01.04 |

| Interleaving : CBQT중에는 선수조건이 필요한 경우가 있다 (14) | 2009.12.07 |

invalid-file

invalid-file